딥러닝을 공부하다 보면 경사 하강법(Gradient Descent) 과 역전파(Backpropagation) 가 가장 중요한 개념으로 등장합니다. 이 두 가지 개념이 없다면 신경망 학습 자체가 불가능하죠! 그런데…

🤔 "경사 하강법이 뭐고, 왜 중요한 거야?"

🤔 "역전파는 또 뭔데? 이 둘이 어떻게 연결되는 거야?"

오늘은 딥러닝의 핵심 원리인 경사 하강법과 역전파를 쉽고 재미있게 알아보겠습니다! 🚀

📌 경사 하강법(Gradient Descent)이란?

경사 하강법은 함수의 최소값을 찾는 최적화 기법입니다. 신경망 학습에서는 손실 함수(Loss Function) 값을 줄이기 위해 사용됩니다.

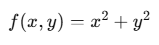

예를 들어, 다음과 같은 함수가 있다고 해보죠.

이 함수는 볼록한 형태를 가지며, 가장 낮은 지점이 원점(0,0)입니다. 우리는 함수의 최소값을 찾기 위해 기울기의 반대 방향으로 이동해야 합니다.

이제, 각 변수에 대해 편미분을 해보겠습니다.

이를 벡터로 나타내면?

바로 이게 기울기 벡터(Gradient Vector) 입니다! 🎯

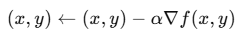

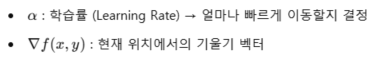

경사 하강법은 다음 수식을 이용하여 가중치를 업데이트합니다.

여기서:

✔ 기울기 벡터 방향으로 가면 함수 값이 증가하고, 반대 방향으로 가면 함수 값이 감소합니다.

즉, 경사 하강법은 기울기의 반대 방향으로 이동하며 손실 함수를 최소화하는 과정입니다! 🚀

🔄 역전파(Backpropagation): 신경망 학습의 핵심

경사 하강법이 손실을 줄이는 방법이라면, 역전파는 손실을 줄이기 위해 기울기를 계산하는 방법입니다.

신경망에서 각 뉴런의 가중치를 조정하려면, 먼저 각 가중치가 손실에 미치는 영향을 계산해야 합니다. 이를 편미분하여 찾는 것이 역전파 알고리즘입니다.

🔹 역전파의 핵심 과정

- 순전파(Forward Propagation)

- 입력 데이터를 네트워크에 통과시켜 예측값을 계산

- 손실 함수 계산

- 예측값과 실제값의 차이를 손실 함수로 표현

- 역전파(Backpropagation) 수행

- 손실 함수를 가중치에 대해 편미분하여 기울기 계산

- 체인 룰(Chain Rule)을 사용하여 각 층의 기울기를 전달

- 경사 하강법 적용

- 가중치를 기울기의 반대 방향으로 업데이트하여 손실 감소

✔ 즉, 역전파는 기울기를 구하는 과정이고, 경사 하강법은 그 기울기를 이용해 가중치를 업데이트하는 과정입니다! 🎯

📉 경사 하강법과 역전파의 관계

✔ 경사 하강법(Gradient Descent) → 기울기의 반대 방향으로 이동하여 손실 최소화 ✔ 역전파(Backpropagation) → 기울기를 계산하여 경사 하강법이 사용할 수 있도록 전달

이 두 가지 개념이 함께 작동해야 신경망이 학습할 수 있습니다! 🚀

🔥 예제: 신경망 학습 과정

- 순전파를 통해 예측값을 계산한다.

- 손실 함수를 사용해 오차를 계산한다.

- 역전파를 사용해 손실이 각 가중치에 미치는 영향을 계산한다.

- 경사 하강법을 적용해 가중치를 업데이트한다.

- 위 과정을 반복하면서 모델이 점점 최적화된다.

💡 즉, 경사 하강법과 역전파는 딥러닝의 핵심 알고리즘이며, 이 둘이 함께 돌아가야 신경망이 학습할 수 있습니다!

🔥 결론: 딥러닝의 핵심은 경사 하강법 + 역전파!

✔ 경사 하강법은 기울기의 반대 방향으로 이동하여 손실을 줄인다. ✔ 역전파는 손실이 각 가중치에 미치는 영향을 계산하는 과정이다. ✔ 둘이 함께 작동해야 신경망이 학습할 수 있다. ✔ 즉, 딥러닝을 이해하려면 반드시 경사 하강법과 역전파를 알아야 한다! 🎯

💡 이제 딥러닝의 핵심 개념이 명확해졌나요? 😆

딥러닝을 공부할 때 "경사 하강법과 역전파는 한 몸이다!" 라고 생각하면 됩니다!

혹시 더 궁금한 점이 있다면 댓글로 남겨주세요! 🚀

'02. 딥러닝' 카테고리의 다른 글

| 00008. [AI 쉽게 이해하기 시리즈] 어텐션 메커니즘이 뭐예요? 초간단 설명 들어갑니다! (0) | 2025.04.03 |

|---|---|

| 00007. [AI 쉽게 이해하기 시리즈] RNN과 트랜스포머의 차이, 진짜 쉽게 설명해드립니다! (0) | 2025.04.03 |

| 00005. 🎢 기울기 벡터는 어디로 가라고 하는 걸까? - 딥러닝의 비밀! (1) | 2025.03.19 |

| 00004. 최적화 알고리즘 비교: Momentum, AdaGrad, RMSprop, Adam (0) | 2025.03.11 |

| 00003. Learning Rate란? 머신러닝과 딥러닝에서의 역할 (0) | 2025.03.11 |